Uvod v obdelavo podatkov v strojnem učenju

Predobdelava podatkov v strojnem učenju je način pretvorbe podatkov iz surove oblike v veliko bolj oblikovano, neuporabno ali želeno obliko. To je sestavna naloga strojnega učenja, ki jo opravi podatkovnik. Ker so zbrani podatki v neobdelani obliki, morda modela ni mogoče izučiti z uporabo. Pomembno je, da te neobdelane podatke previdno obdelamo, da iz njih naredimo pravilno razlago in se na koncu izognemo negativnemu rezultatu napovedi. Skratka, kakovost našega algoritma za učenje je zelo odvisna od vrste nabora podatkov, s katerim smo napajali model, tako da se za vzdrževanje te kakovosti uporablja predhodna obdelava podatkov.

Podatki, zbrani za usposabljanje modela, so iz različnih virov. Ti zbrani podatki so na splošno v njihovi surovi obliki, tj. Lahko imajo zvoke, kot so manjkajoče vrednosti, ustrezne informacije, številke v obliki niza itd. Ali pa so lahko nestrukturirani. Predobdelava podatkov povečuje učinkovitost in natančnost modelov strojnega učenja. Ker pomaga pri odstranjevanju teh hrupov in nabora podatkov ter daje pomen naboru podatkov

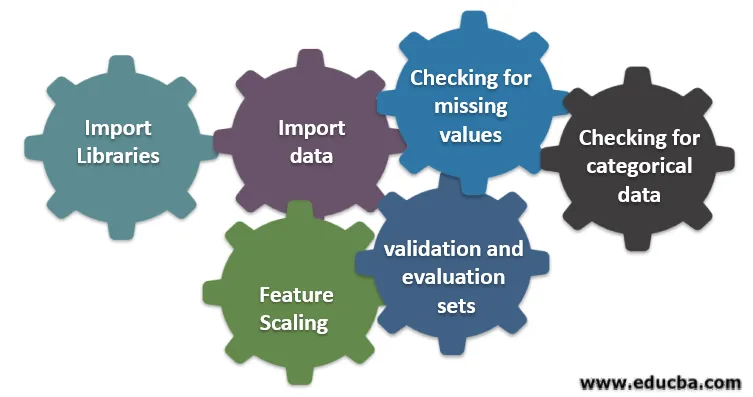

Šest različnih korakov vključenih v strojno učenje

Sledi šest različnih korakov strojnega učenja za izvajanje predobdelave podatkov:

1. korak: Uvoz knjižnic

2. korak: Uvoz podatkov

3. korak: Preverjanje manjkajočih vrednosti

4. korak: Preverjanje kategoričnih podatkov

5. korak: Prilagajanje velikosti funkcije

6. korak: Razdelitev podatkov na sklope usposabljanja, potrjevanja in ocenjevanja

Podrobneje razberemo vsakega od teh korakov:

1. Uvozi knjižnice

Prvi korak je uvoz nekaterih pomembnih knjižnic, potrebnih za predhodno obdelavo podatkov. Knjižnica je zbirka modulov, ki jih je mogoče poklicati in uporabiti. V pythonu imamo veliko knjižnic, ki nam pomagajo pri predhodni obdelavi podatkov.

Nekaj naslednjih pomembnih knjižnic v pythonu je:

- Številka: knjižnica se večinoma uporablja za izvajanje ali uporabo zapletenih matematičnih izračunov strojnega učenja. Koristno je pri izvajanju operacije na večdimenzionalnih nizih.

- Pande : To je knjižnica odprtih virov, ki zagotavlja visoko zmogljivost in enostavna uporaba podatkovnih struktur in orodij za analizo podatkov v pythonu. Zasnovan je tako, da je delo z razmerjem in označenimi podatki enostavno in intuitivno.

- Matplotlib: To je knjižnica za vizualizacijo, ki jo python ponuja za 2D ploskve o matriki. Zgrajen je na numeričnem nizu in zasnovan za delo s širšim skladom Scipy. Vizualizacija nabora podatkov je koristna v scenariju, kjer so na voljo veliki podatki. Parcele, ki so na voljo v matplot lib-ju, so črta, drog, raztros, histogram itd

- Seaborn: To je tudi knjižnica za vizualizacijo, ki jo je dal python. Ponuja vmesnik na visoki ravni za risanje privlačnih in informativnih statističnih grafov.

2. Uvozi nabor podatkov

Ko so knjižnice uvožene, je naš naslednji korak nalaganje zbranih podatkov. Za uvoz teh nizov podatkov se uporablja knjižnica Pandas. Večinoma so nabori podatkov na voljo v oblikah CSV, saj so majhne, kar omogoča hitro obdelavo. Torej, za nalaganje datoteke csv s funkcijo read_csv knjižnice pande. Različni drugi formati nabora podatkov so vidni

Ko je nabor podatkov naložen, ga moramo pregledati in iskati morebitne hrupe. To moramo narediti matriko X in opazovalni vektor Y glede na X.

3. Preverjanje manjkajočih vrednosti

Ko ustvarite matrico funkcij, boste morda našli nekaj manjkajočih vrednosti. Če se tega ne bomo lotili, lahko to povzroči težave v času treninga.

Obstajata dva načina obravnavanja manjkajočih vrednosti:

- Odstranjevanje celotne vrstice, ki vsebuje manjkajočo vrednost, vendar obstaja možnost, da boste morda izgubili nekaj pomembnih informacij. To je lahko dober pristop, če je velikost nabora podatkov velika.

- Če ima numerični stolpec manjkajočo vrednost, lahko vrednost ocenite tako, da vzamete srednjo, mediano, način itd.

4. Preverjanje kategoričnih podatkov

Podatki v naboru podatkov morajo biti v številčni obliki, da se na njih lahko izračuna. Ker modeli strojnega učenja vsebujejo zapleteno matematično računanje, jim ne moremo dovajati neštevilčne vrednosti. Torej, pomembno je pretvoriti vse besedilne vrednosti v numerične vrednosti. Za pretvorbo teh kategoričnih vrednosti v numerične vrednosti se uporablja razred naučenih LabelEncoder ().

5. Prilagajanje velikosti

Vrednosti neobdelanih podatkov se zelo razlikujejo, kar lahko povzroči pristransko usposabljanje modela ali pa na koncu poveča računske stroške. Zato jih je pomembno normalizirati. Razvrščanje značilnosti je tehnika, ki se uporablja za prenos vrednosti podatkov v krajši obseg.

Metode, ki se uporabljajo za skaliranje lastnosti, so:

- Spreminjanje obsega (min-max normalizacija)

- Srednja normalizacija

- Standardizacija (normalizacija Z-ocene)

- Prilagoditev na dolžino enote

6. Razdelitev podatkov na sklope za usposabljanje, potrjevanje in ocenjevanje

Nazadnje moramo svoje podatke razdeliti na tri različne sklope, set za usposabljanje za treniranje modela, validacijski niz za potrditev natančnosti našega modela in na koncu testni set za preverjanje učinkovitosti našega modela na splošnih podatkih. Pred delitvijo nabora podatkov je pomembno, da se nabor podatkov premešča, da se prepreči pristranskost. Idealen delež za razdelitev nabora podatkov je 60:20:20, tj. 60% kot nastavljeni trening, 20% kot testni in validacijski set. Za razdelitev nabora uporabite dvakrat vlak_test_split iz sklearn.model_selection. Enkrat razdelite nabor podatkov na niz vlakov in validacije in nato razdelite preostali nabor vlakov na vlak in preskusni niz.

Zaključek - Predobdelava podatkov v strojnem učenju

Predobdelava podatkov je nekaj, kar zahteva praksa. Ni podobna preprosti strukturi podatkov, v kateri se za reševanje težave učite in uporabljate neposredno. Če želite dobro znanje o čiščenju nabora podatkov ali kako vizualizirati vaš nabor podatkov, morate sodelovati z različnimi nabori podatkov.

Bolj kot boste uporabljali te tehnike, boljše boste razumeli. To je bila splošna ideja, kako ima obdelava podatkov pomembno vlogo pri strojnem učenju. Poleg tega smo videli tudi korake, potrebne za predhodno obdelavo podatkov. Zato naslednjič, preden začnete trenirati model z uporabo zbranih podatkov, ne pozabite uporabiti predhodne obdelave podatkov.

Priporočeni članki

To je priročnik za obdelavo podatkov v strojnem učenju. Tukaj razpravljamo o uvodu, Šest različnih korakih, vključenih v strojno učenje. Obiščite lahko tudi druge naše predlagane članke, če želite izvedeti več -

- Pomen umetne inteligence

- IoT tehnologija

- Vrste PL / SQL podatkov

- Vrste podatkov o panju

- R podatkovne vrste