Uvod v arhitekturo velikih podatkov

Kadar gre za upravljanje težkih podatkov in izvajanje kompleksnih operacij na teh množičnih podatkih, obstaja potreba po uporabi velikih podatkovnih orodij in tehnik. Ko rečemo, da uporabljamo orodja in tehnike velikih podatkov, dejansko mislimo, da želimo uporabiti različno programsko opremo in postopke, ki so v velikem podatkovnem ekosistemu in njegovi sferi. Za vsako uporabo ni nobene splošne rešitve, zato jo je treba izdelati in narediti na učinkovit način v skladu s poslovnimi zahtevami določenega podjetja. Zato je treba uporabiti različne arhitekture velikih podatkov, saj bo zaradi kombinacije različnih tehnologij dosežen rezultat uporabe. Z vzpostavitvijo fiksne arhitekture je mogoče zagotoviti, da bo za zahtevani primer uporabe zagotovljena izvedljiva rešitev.

Kaj je arhitektura velikih podatkov?

- Ta arhitektura je zasnovana tako, da obravnava postopek zaužitja, obdelavo podatkov in analizo podatkov, kar je preveliko ali zapleteno za ravnanje s tradicionalnimi sistemi za upravljanje podatkovnih baz.

- Različne organizacije imajo za svoje organizacije različne pragove, nekatere imajo nekaj sto gigabajtov, za druge pa celo nekaj terabajtov ni dovolj dobra vrednost praga.

- Ker se ta dogodek zgodi, če pogledate na blagovne sisteme in blagovno skladišče, so se vrednosti in stroški skladiščenja znatno zmanjšali. Obstaja ogromno različnih podatkov, ki zahtevajo različne načine oskrbe.

- Nekateri od njih so paketni podatki, ki pridejo ob določenem času, zato je treba opravila načrtovati na podoben način, medtem ko nekateri drugi pripadajo razredu pretakanja, kjer je treba zgraditi sprotni tok cevovoda v realnem času, da zadovolji vse zahteve. Vse te izzive rešuje arhitektura velikih podatkov.

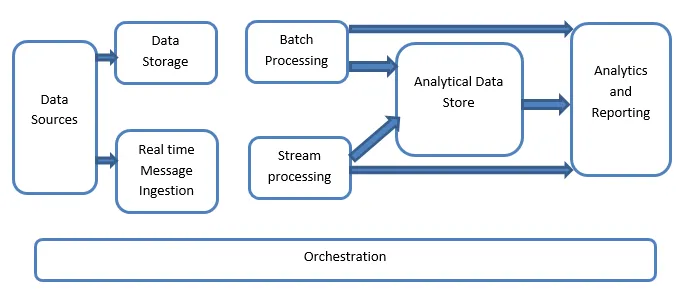

Pojasnilo velike arhitekture podatkov:

Sistemi velikih podatkov vključujejo več vrst delovne obremenitve in so na splošno razvrščeni na naslednji način:

- Kadar so veliki viri, ki temeljijo na podatkih, počivajo v paketni obdelavi.

- Velika obdelava podatkov v gibanju za sprotno obdelavo.

- Raziskovanje interaktivnih velikih podatkovnih orodij in tehnologij.

- Strojno učenje in napovedne analize.

1. Viri podatkov

Viri podatkov vključujejo vse tiste zlate vire, od koder je zgrajen cevovod za odvzem podatkov, zato lahko rečemo, da je to izhodišče velikega podatkovnega omrežja.

Primeri vključujejo:

(i) shranjevanje podatkovnih aplikacij, kakršne so relacijske baze podatkov

(ii) Datoteke, ki jih ustvari več aplikacij in so večinoma del statičnih datotečnih sistemov, na primer spletnih strežniških datotek, ki ustvarjajo dnevnike.

(iii) IoT naprave in drugi viri podatkov v realnem času.

2. Shranjevanje podatkov

Sem spadajo podatki, ki se upravljajo za paketno vgrajene operacije in so shranjeni v shrambah datotek, ki so porazdeljene v naravi in so zmožne tudi shranjevati velike količine velikih datotek različnih datotek. Imenuje se podatkovno jezero. To je na splošno del, v katerem so na voljo shrambe Hadoop, kot so HDFS, Microsoft Azure, AWS, GCP, skupaj z zabojniki blob.

3. Serijska obdelava

Vsi podatki so ločeni v različne kategorije ali sklope, kar uporablja dolgotrajna opravila, ki se uporabljajo za filtriranje in združevanje ter za pripravo podatkov o obdelanem stanju za analizo. Ta opravila običajno uporabljajo vire, jih obdelujejo in zagotavljajo izhod obdelanih datotek novim datotekam. Paketna obdelava se izvaja na različne načine z uporabo opravil v Pive ali U-SQL opravil ali z uporabo Sqoop ali Pig skupaj z nalogi reduktorjev po meri, ki so običajno napisani v kateri koli od Java ali Scala ali kateri koli drugi jezika, kot je Python.

4. Zaužitje sporočila v realnem času

To vključuje, v nasprotju s paketno obdelavo, vse tiste sisteme pretakanja v realnem času, ki skrbijo za podatke, ki se generirajo zaporedno in v fiksnem vzorcu. To je pogosto preprost podatkovni zaboj ali shramba, ki je odgovorna za vsa dohodna sporočila, ki se spustijo v mapo, ki se nujno uporablja za obdelavo podatkov. Vendar obstaja večina rešitev, za katere je potrebna potreba po zaužitju za shranjevanje na sporočilu, ki deluje kot medpomnilnik sporočil in podpira tudi obdelavo na osnovi obsega, zagotavlja sorazmerno zanesljivo dostavo skupaj z drugo semantiko čakanja na sporočanje. Možnosti vključujejo tiste, kot so Apache Kafka, Apache Flume, vozlišča dogodkov iz Azure itd.

5. Stream Processing

Med zaužitjem sporočila v realnem času in obdelavo tokov je majhna razlika. Prvi upošteva zaužitje podatkov, ki se najprej zbirajo in nato uporabijo kot orodje za naročanje v obliki objave. Na drugi strani se pretočna obdelava uporablja za ravnanje z vsemi pretočnimi podatki, ki se pojavljajo v oknih ali tokovih, nato pa podatke zapiše v izhodno korito. To vključuje Apache Spark, Apache Flink, Storm itd.

6. shramba podatkov na podlagi analitike

To je shramba podatkov, ki se uporablja v analitične namene, zato se že obdelani podatki poizvedujejo in analizirajo z uporabo analitičnih orodij, ki lahko ustrezajo BI rešitvam. Podatki se lahko predstavijo tudi s pomočjo tehnologije skladišča podatkov NoSQL, kot je HBase, ali kakršne koli interaktivne uporabe baze panj, ki lahko zagotovi odvzem metapodatkov v shrambi podatkov. Orodja vključujejo Hive, Spark SQL, Hbase itd.

7. Poročanje in analiza

Vpogled je treba ustvariti na obdelanih podatkih, kar učinkovito storijo orodja za poročanje in analizo, ki uporabljajo njihovo vdelano tehnologijo in rešitev za ustvarjanje uporabnih grafov, analiz in vpogledov, koristnih za podjetja. Orodja vključujejo Cognos, Hyperion itd.

8. Orkestracija

Velike rešitve, ki temeljijo na podatkih, sestavljajo postopke, povezane s podatki, ki se ponavljajo po naravi in so prav tako zajeti v delovne tokove, ki lahko pretvorijo izvorne podatke in tudi premaknejo podatke po virih, pa tudi ponore in naložijo v trgovinah in se potisnejo v analitične enote. Primeri vključujejo Sqoop, oozie, tovarno podatkov itd.

Zaključek

V tej objavi beremo o veliki arhitekturi podatkov, ki je potrebna, da se te tehnologije uporabijo v podjetju ali organizaciji. Upam, da vam je bil naš članek všeč.

Priporočeni članki

To je vodnik za arhitekturo velikih podatkov. Tukaj razpravljamo, kaj so veliki podatki? in tudi razložili smo arhitekturo velikih podatkov skupaj s blokovnim diagramom. Če želite izvedeti več, lahko preberete tudi druge naše predlagane članke -

- Tehnologije velikih podatkov

- Analiza velikih podatkov

- Poklic v velikih podatkih

- Vprašanja o intervjuju z Big Data

- 8 najboljših naprav IoT, ki jih morate vedeti

- Vrste združitev v Spark SQL (primeri)