Razlika med Hadoopom in SQL

Ogromni podatki, ustvarjeni vsako sekundo prek družbenih medijev, kot so Facebook, Twitter in Instagram, so utrli pot razvoju Hadoop / Big Data Ekosistema. Izraz "3V", ki se nanaša na glasnost, hitrost in verodostojnost, določa pomembnost Hadoopa za ravnanje s pretočnimi podatki. Danes se podatki ustvarjajo iz več virov, ki jih je treba integrirati za različne namene, kot so poročanje, analiza podatkov in raziskovanje ter za centralizirano shranjevanje podatkov. Ko to počnemo, se pri tradicionalnih pristopih, kot so prostor, dostop, celovitost, struktura in pasovna širina, pojavljajo številna vprašanja. Za reševanje vseh teh težav Hadoop ponuja okvir, ki omogoča obdelavo podatkov z veliko velikostjo, lažji dostop, visoko razpoložljivost in dinamično nalaganje podatkov. Ima okvir porazdeljenega datotečnega sistema (HDFS) za shranjevanje podatkov in vgrajenega procesorja poizvedb, imenovan „Zmanjšanje zemljevida“ za analizo in obdelavo podatkov, shranjenih v HDFS.

Primerjava med Hadoop Vs SQL

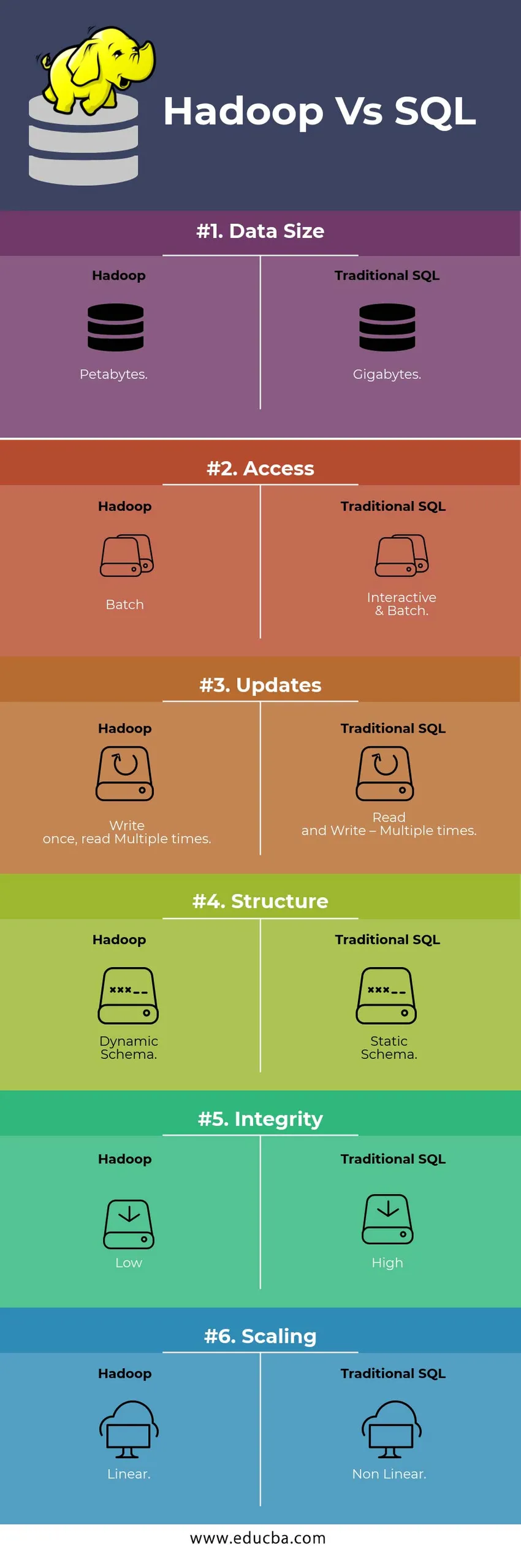

Spodaj je top 6 razlik med Hadoop Vs SQL

Ključne razlike med Hadoop Vs SQL

Spodaj je razlika med Hadoopom in SQLom naslednja

- Shema na WRITE VS PREBERITE

Na splošno v tradicionalni zbirki podatkov med nalaganjem / migracijo podatkov iz ene baze v drugo sledi shema na pristopu Write. Zaradi tega se postopek nalaganja podatkov vzbudi / prekine in povzroči zavrnitev zapisov zaradi razlike v strukturi izvorne in ciljne tabele, medtem ko so v sistemu Hadoop vsi podatki shranjeni v HDFS in podatki so centralizirani.

Okvir Hadoop se v glavnem uporablja za proces analize podatkov. Tako podpira vse tri kategorije podatkov, tj strukturirane, polstrukturirane in nestrukturirane podatke in omogoča shemo pri bralnem pristopu.

- Strukturirani podatki imajo točno določeno obliko. g .: Datoteka XML

- Podatki Semi Strukture so ohlapnejši; Lahko / nima sheme. g .: preglednica

- Nestrukturirani podatki nimajo posebne strukture ali sheme. Npr .: navaden tekst ali slika.

Hadoop učinkovito deluje z nestrukturiranimi podatki, saj lahko interpretira podatke v času obdelave.

| Pristop | Prednost | Dis Prednost |

| Shema za pisanje | · Vnaprej določene strukture

· Hitrejše branje. Npr .: tradicionalni RDBMS. | Počasno nalaganje podatkov

Visoka zamuda |

| Shema ob branju | · Dinamična struktura

· Hitro pisanje in branje. Npr .: Hadoop | Hitro nalaganje podatkov

Nizka zakasnitev |

Tabela : Shema na WRITE VS Scheme on READ.

- SKLADNOST IN STROŠKI

Hadoop Framework je zasnovan za obdelavo velike količine podatkov. Kadar koli se povečuje velikost podatkov, se lahko kopici dodajo dodatni viri, kot je podatkovno vozlišče, zelo enostavno kot tradicionalni pristop k dodeljevanju statičnega pomnilnika. Časa in proračuna je za njihovo izvajanje razmeroma manj, prav tako Hadoop zagotavlja lokalnost podatkov, kadar so podatki na voljo v vozlišču, ki je izvedlo opravilo.

- NAPAKA

V tradicionalnih RDBMS, ko se podatki izgubijo zaradi korupcije ali kakršne koli težave z omrežjem, potrebuje več časa, stroškov in sredstev, da se izgubljeni podatki povrnejo. Toda Hadoop ima mehanizem, kjer imajo podatki najmanj tri stopnje faktorja podvajanja za podatke, ki so shranjeni v HDFS. Če eno od podatkovnih vozlišč, ki hranijo podatke, ne uspe, lahko podatke zlahka potegnete iz drugih podatkovnih vozlišč z veliko razpoložljivostjo podatkov. Tako so podatki zlahka dostopni uporabnikom ne glede na napako.

- FUNKCIONALNO PROGRAMIRANJE

Hadoop podpira pisanje funkcionalnih programov v jezikih, kot so java, skala in python. Za vsako aplikacijo, ki zahteva kakršno koli dodatno funkcijo, je mogoče implementirati z registracijo funkcij, ki jih UDF definira za uporabnika, v HDFS. V RDBMS ni možnosti pisanja UDF in to povečuje zapletenost pisanja SQL. Poleg tega lahko do podatkov, shranjenih v HDFS, dostopate v vseh ekosistemih Hadoopa, kot so Hive, Pig, Sqoop in HBase. Če je napisan UDF, ga lahko uporabi katera koli od zgoraj omenjenih aplikacij. Povečuje zmogljivost in podporo sistema.

- OPTIMIZACIJA

Hadoop shranjuje podatke v HDFS in Process, čeprav Map Reduce z ogromnimi tehnikami optimizacije. Najbolj priljubljene tehnike za obdelavo podatkov so razdelitev in shranjevanje shranjenih podatkov. Particiranje je pristop za shranjevanje podatkov v HDFS z delitvijo podatkov na podlagi stolpca, omenjenega za particijo. Ko se podatki vbrizgajo ali naložijo v HDFS, identificira particijski stolpec in podatke potisne v zadevni imenik particij. Torej, poizvedba pridobi rezultat, tako da neposredno pridobi podatke iz particioniranega imenika. To zmanjša skeniranje celotne tabele, izboljša čas odziva in prepreči zamude.

Drug pristop se imenuje združevanje podatkov. To analitiku omogoča enostavno distribucijo podatkov med podatkovnimi vozlišči. Vsa vozlišča bodo razdelila enako število podatkov. Stolpec za vedro je izbran tako, da ima najmanjše število kardinalnosti.

V tradicionalni metodi SQL teh pristopov ni.

- VRSTA PODATKOV

V tradicionalnem pristopu je podprti tip podatkov zelo omejen. Podpira samo strukturirane podatke. Tako bo čiščenje in formatiranje sheme podatkov trajalo več časa. Toda Hadoop podpira zapletene vrste podatkov, kot so Array, Struct in Map. To spodbuja uporabo različnih vrst nabora podatkov, ki se uporabljajo za nalaganje podatkov. Za Ex: Podatke XML lahko naložimo z definiranjem podatkov z elementi XML, ki vsebujejo zapletene vrste podatkov.

- PRIMER PODATKOV

Za tradicionalni sistem baz podatkov je na voljo zelo manj vgrajenih tehnik stiskanja. Toda za okvir Hadoop obstaja veliko tehnik stiskanja, kot so gzib, bzip2, LZO in snappy. Privzeti način stiskanja je LZ4. Celo tabele je mogoče stisniti s pomočjo tehnik stiskanja, kot so Parquet, ORC. Tehnike stiskanja pomagajo, da bodo tabele zavzele zelo manj prostora, povečajo pretok in hitrejše izvajanje poizvedb.

Hadoop Vs SQL primerjalna tabela

| Značilnosti | Tradicionalni SQL | Hadoop |

| Velikost podatkov | Gigabajti | Petabajti |

| Dostop | Interaktivni & Batch | Šarža |

| Posodobitve | Branje in pisanje - večkrat | Napišite enkrat, preberite večkrat |

| Struktura | Statična shema | Dinamična shema |

| Celovitost | Visoka | Nizka |

| Skaliranje | Nelinearno | Linearno |

Tabela : Primerjava med tradicionalnim Hadoop in SQL Framework.

Zaključek - Hadoop Vs SQL

Na splošno je Hadoop stopil pred tradicionalni SQL glede stroškov, časa, zmogljivosti, zanesljivosti, podpornosti in razpoložljivosti podatkov zelo veliki skupini uporabnikov. Da bi učinkovito obvladovali ogromno količino podatkov, ustvarjenih vsak dan, okvir Hadoop pomaga pri pravočasnem zajemanju, shranjevanju, obdelavi, filtriranju in končnem shranjevanju v središču.

Priporočeni članek

- Hadoop vs Hive - odkrijte najboljše razlike

- Naučite se 10 koristnih razlik med Hadoopom in Redshiftom

- HADOOP vs RDBMS | Poznajte 12 uporabnih razlik

- Apache Hadoop in Apache Spark | Top 10 primerjav, ki jih moraš vedeti!

- Hadoop vs Spark: Lastnosti