Kaj je ekosistem Apache Hadoop?

Apache Hadoop Ecosystem je okvir ali odprtokodna podatkovna platforma, ki je namenjena shranjevanju in preučevanju ogromnih zbirk podatkov nestrukturiranih. Po vsem svetu se na številnih digitalnih platformah z vodilno inovativno tehnologijo velikih podatkov poganja tona podatkov. Poleg tega je bil Apache Hadoop prvi, ki je dobil to pot inovacij.

Kaj je sestavljeno iz Hadoop Data arhitekture / ekosistema?

Ekosistem Hadoop ni programski jezik ali storitev, je okvir ali platforma, ki skrbi za velike težave s podatki. Lahko ga prepoznate kot paket, ki zajema različne storitve, kot so shranjevanje, zaužitje, vzdrževanje in analiza znotraj njega. Nato preučite in dobite natančno razmišljanje o tem, kako službe delujejo izključno in v sodelovanju. Arhitektura Apache Hadoop obsega različne inovacije in elemente Hadoop, s pomočjo katerih je mogoče celo učinkovito zapleteno informacijsko vprašanje rešiti.

Sledi prikaz vsakega dela: -

1) Namenode: Vodi postopek obveščanja

2) Datanode: informacije sestavi v lokalno shrambo. Shranjevanje vseh informacij na edinstvenem mestu se ne predlaga nenehno, saj lahko v primeru izpada izgubi informacije.

3) Sledilnik opravil: Prejemajo naloge, dodeljene suženjskemu vozlišču

4) Zemljevid: Vzame podatke iz toka in vsaka vrstica se deli tako, da jih razdeli na različna polja

5) Manjše: Tu se polja, pridobljena z Zemljevidom, zbirajo ali povezujejo med seboj

Ekosistem Apache Hadoop - korak za korakom

Vsak element ekosistema Hadoop, kot posebni vidiki, je očiten. Celovita perspektiva strukture Hadoop ponuja omembe vredno kakovost distribuiranim datotečnim sistemom (HDFS), Hadoop YARN, Hadoop MapReduce in Hadoop MapReduce iz ekosistema Hadoop. Hadoop celo daje vsaki knjižnici Java, pomembne zapise o Javi, odsev ravni OS, prednosti in skripte za upravljanje Hadoop-a, Hadoop YARN je metoda za opisovanje poslovanja in upravljanje virov. V konfiguraciji Hadoop HDFS omogoča visok prehod do informacij o aplikacijah, Hadoop MapReduce pa vzporedno pripravo obsežnih podatkovnih sortimentov na osnovi YARN.

Pregled ekosistema Apache Hadoop

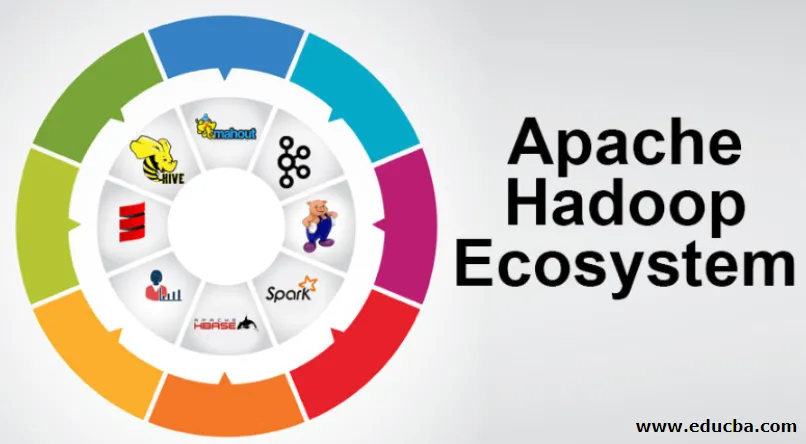

To je temeljna tema, ki jo je treba razumeti, preden začnete sodelovati z ekosistemom Hadoop. Spodaj so ključne sestavine:

- HDFS: To je osrednji del ekosistema Hadoop in lahko prihrani ogromno nestrukturiranih, strukturiranih in polstrukturiranih informacij.

- PRIJAZ: Podoben je ekosistemu Hadoop in vse ravnanje poteka neposredno tukaj, kar lahko vključuje dodelitev sredstev, načrtovanje in načrtovanje ukrepov.

- MapReduce: To je mešanica dveh procesov, opisana kot Map and Reduce in vsebuje bistveno pripravo delov, ki sestavljajo ogromne zbirke informacij z uporabo vzporednih in razpršenih algoritmov znotraj ekosistema Hadoop.

- Apache Pig: To je jezik postopka, ki se uporablja za vzporedno obdelavo aplikacij za obdelavo obsežnih zbirk informacij v stanju Hadoop in ta jezik je možnost za programiranje Java.

- HBase: Gre za odprtokodno in nepovezano bazo podatkov ali NoSQL. Tako krepi vse vrste informacij, s katerimi se lahko spoprime s katero koli vrsto informacij znotraj okvira Hadoop.

- Mahout, Spark MLib: Mahout se uporablja za strojno učenje in daje naravi za ustvarjanje aplikacij za strojno učenje.

- Zookeeper: Če se želite ukvarjati s skupinami, lahko uporabimo Zookeeper, sicer ga imenujemo gospodar koordinacije, ki lahko daje zanesljive, hitre in razvrščene operativne uprave za skupine Hadoop.

- Oozie: Apache Oozie upravlja načrtovanje dela in deluje kot budilka in storitve ure v ekosistemu Hadoop.

- Ambari: Gre za program programske fundacije Apache, ki lahko ekosistem Hadoop izvaja postopoma prožno.

Hadoop PRIJA:

Pomislite na JARN kot na pamet ekosistema Hadoop. Pokaže celoten postopek obdelave z dodeljevanjem sredstev in plačilnimi nalogami.

Ima dva pomembna segmenta, ki sta ResourceManager in NodeManager.

- ResourceManager: - Spet je glavno vozlišče v operacijskem oddelku. Dobi pripravljajoče poizvedbe in nato pokaže dele poizvedb, ki se nanašajo na NodeManagers, kjer se zgodi resnično ravnanje.

- NodeManagers: - Ti so nameščeni na vsakem DataNode. Zadolžen je za izvedbo naloge na vsaki DataNode.

Kako deluje apache Hadoop?

- Namenjen je vzponu s posameznih strežnikov do ogromne količine strojev, pri čemer vsak zagotavlja lokalno računanje in zmogljivost. Namesto da bi bila odvisna od opreme za prenos visoke dostopnosti, je knjižnica sama namenjena razlikovanju in odpravljanju razočaranj na aplikacijskem sloju, tako da preko kopice osebnih računalnikov prenaša izjemno dostopno storitev, od katerih je vsak lahko nagnjen k razočaranjem.

- Vendar poglejte še naprej, in pri delu se bistveno povečuje čar. Hadoop je popolnoma modularen, kar pomeni, da lahko praktično nadomestite praktično kateri koli od njegovih segmentov z nadomestnim programskim orodjem. Zaradi tega je arhitektura fantastično prilagodljiva, prav tako močna in učinkovita.

Apache Hadoop Spark:

- Apache Spark je sistem za sprotno analizo informacij v razpršeni računalniški nastavitvi. Izvaja izračune v pomnilniku, s katerimi gradi hitrost ravnanja z informacijami.

- Hitreje je za obdelavo obsežnih informacij, saj uporablja izračune v pomnilniku in različne izboljšave. Po teh linijah je potrebna velika sila obdelave.

Kako deluje Apache Pig?

- Apache Pig je koristen sistem Yahoo je bil razvit za učinkovito in gladko preučevanje obsežnih informacijskih položajev. Ponuja nekaj najvišjega nivoja jezika toka informacij prašička latinščina, ki je izboljšan, razširljiv in preprost za uporabo.

- Izjemna sestavina prašičjih programov, v kateri je njihova sestava na voljo za veliko paralelizacijo, omogoča preprosto skrb za obsežne informacije.

Primer za prašiče:

- Podatki o zasebnem zdravstvenem varstvu posameznika so zasebni in jih ne bi smeli razkriti drugim. Te podatke bi bilo treba skriti, da bi ohranili tajnost, vendar so informacije o zdravstvenih storitvah ogromne, da je priznavanje in izključevanje posameznih zdravstvenih podatkov nujno. Pod takšnimi pogoji lahko zdravilo Apache Pig uporabimo za odkrivanje zdravstvenih podatkov.

Zaključek:

- Začrtano je, da se z enega strežnika povzpnemo do ogromne količine strojev, ki zagotavljajo računanje in zmogljivosti v bližini. Vendar poglejte še naprej in v službi je vse več očaranja.

- Hadoop je popolnoma modularen, kar pomeni, da lahko nadomestite praktično kateri koli njegov del za nadomestno programsko orodje. Zaradi tega je struktura fantastično prilagodljiva, prav tako močna in učinkovita.

Priporočeni članki

To je vodnik za ekosistem Apache Hadoop. Tu smo razpravljali o tem, kaj je Apache Hadoop ekosistema? pregled arhitekture Hadoop in delovanja ekosistema Hadoop. Če želite izvedeti več, lahko preberete tudi druge naše predlagane članke -

- Hadoop komponente ekosistema

- Kako namestiti Apache

- Trening iskre za Apache

- Kariera v Hadoopu