Uvod v odpravo nazaj

Ko človek in stroj trkata v smeri digitalne evolucije, se različni tehniki obračunavajo, da se ne samo usposobijo, ampak tudi pametno usposobijo, da lahko bolje spoznajo predmete iz resničnega sveta. Takšna tehnika, ki je bila uvedena prej, imenovana "nazaj odstranjevanje", ki je želela dati prednost nepogrešljivim lastnostim, hkrati pa izkoreninjenje nujnih lastnosti, da bi se v računalniku omogočila boljša optimizacija. Celotno znanje stroja za prepoznavanje predmetov je sorazmerno z značilnostmi, ki jih ima v mislih.

Funkcije, ki na napovedan izhod nimajo nobene reference, je treba izprazniti iz stroja in zaključiti z odstranjevanjem nazaj. Dobra natančnost in časovna zapletenost prepoznavanja katerega koli stvarnega besednega predmeta s strani Stroja sta odvisna od njegovega učenja. Torej odprava nazaj igra svojo togo vlogo pri izbiri funkcij. Upošteva stopnjo odvisnosti lastnosti od odvisne spremenljivke in v pomenu najde pomen njene pripadnosti. Da bi to akreditirali, preveri vnaprej določeno stopnjo s standardno stopnjo pomembnosti (recimo 0, 06) in sprejme odločitev za izbiro funkcij.

Zakaj se lotimo nazaj odprave ?

Nebistvene in odvečne lastnosti poganjajo kompleksnost strojne logike. Po nepotrebnem požre čas in vire modela. Torej, omenjena tehnika igra kompetentno vlogo, da ponazori model na preprosto. Algoritem goji najboljšo različico modela z optimizacijo njegove zmogljivosti in izkoriščanjem potrebnih namenskih virov.

To zmanjšuje najmanj pomembne lastnosti modela, ki povzročajo hrup pri odločanju o regresijski liniji. Nepomembne lastnosti predmeta lahko povzročijo napačno razvrščanje in napovedovanje. Nepomembne lastnosti podjetja lahko pomenijo neskladje v modelu glede na druge pomembne lastnosti drugih predmetov. Odprava nazaj krepi vgradnjo modela v najboljši primer. Zato je v modelu priporočljivo odstranjevanje nazaj.

Kako uporabiti nazaj odstranjevanje?

Odprava nazaj začne z vsemi spremenljivkami lastnosti, pri čemer se preizkusi z odvisno spremenljivko pod izbranim merilom modela. Začne izkoreninjenje tistih spremenljivk, ki poslabšajo regresijo. Ponavljanje tega brisanja ponavljamo, dokler model ne doseže ustreznosti. Spodaj so koraki za izvajanje odprave nazaj:

1. korak: Izberite ustrezno raven pomembnosti, ki bo nastala v modelu stroja. (Vzemite S = 0, 06)

2. korak: Napolnite vse razpoložljive neodvisne spremenljivke modela glede na odvisno spremenljivko in računalnik naklona in prestrezite, da narišete regresijsko ali prilagodljivo črto.

3. korak: Preidite z vsemi neodvisnimi spremenljivkami, ki imajo najvišjo vrednost (vzemite I), enega za drugim in nadaljujte z naslednjim zdravico: -

a) Če sem> S, izvedite 4. korak.

b) Else splavi in model je popoln.

4. korak: Odstranite izbrano spremenljivko in povečajte prehod.

5. korak: Znova kovajte model in ponovno izračunajte nagib in prestrezanje vgradne črte z ostanki spremenljivk.

Zgoraj navedeni koraki so povzeti v zavrnitvi tistih značilnosti, katerih stopnja pomembnosti je nad izbrano vrednostjo pomembnosti (0, 06), da se izognemo prekomerni klasifikaciji in prekomerni uporabi virov, ki so bili zapleteni.

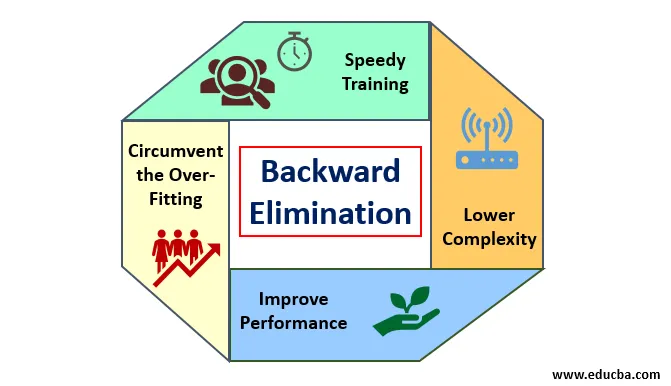

Zasluge in pomanjkljivosti odprave nazaj

Spodaj je podrobno predstavljenih nekaj prednosti in pomanjkljivosti odprave nazaj:

1. Zasluge

Zasluge za odpravo nazaj so naslednje:

- Hitro usposabljanje: Stroj je usposobljen z naborom razpoložljivih funkcij vzorca, ki je narejen v zelo kratkem času, če so iz modela odstranjene nepomembne lastnosti. Hitro usposabljanje nabora podatkov se pojavi šele, ko se model ukvarja s pomembnimi lastnostmi in izključuje vse spremenljivke hrupa. Vleče preprosto zapletenost treninga. Toda model ne bi smel biti premajhen, kar se pojavi zaradi pomanjkanja lastnosti ali neustreznih vzorcev. Vzorec mora biti v številnih modelih za najboljšo razvrstitev. Čas, potreben za usposabljanje modela, mora biti krajši, hkrati pa ohranjati natančnost klasifikacije in ne sme biti spremenljivk pod napovedjo.

- Manjša zapletenost: Kompleksnost modela se zdi velika, če model razmišlja o obsegu lastnosti, vključno s hrupom in nepovezanimi funkcijami. Model porabi veliko prostora in časa za obdelavo takega razpona funkcij. To lahko poveča hitrost natančnosti prepoznavanja vzorcev, lahko pa vsebuje tudi hrup. Da se znebimo tako velike zapletenosti modela, algoritem za odstranjevanje nazaj igra potrebno vlogo tako, da iz modela odstrani neželene lastnosti. Poenostavlja logiko obdelave modela. Le nekaj bistvenih značilnosti je dovolj, da dobimo ustrezen videz, ki vsebuje razumno natančnost.

- Izboljšanje zmogljivosti: Uspešnost modela je odvisna od mnogih vidikov. Model je podvržen optimizaciji z uporabo odprave nazaj. Optimizacija modela je optimizacija nabora podatkov, ki se uporablja za usposabljanje modela. Učinkovitost modela je sorazmerna s hitrostjo optimizacije, ki temelji na pogostosti pomembnih podatkov. Proces odstranjevanja nazaj ni namenjen zagonu sprememb iz katerega koli nizkofrekvenčnega napovedovalca. Spreminjanje se začne šele iz visokofrekvenčnih podatkov, saj je večinoma kompleksnost modela odvisna od tega dela.

- Obkroži prekomerno prileganje : Do situacije prekomerne namestitve pride, ko je model dobil preveč nabora podatkov in se izvaja klasifikacija ali napovedovanje, v katerem so nekateri napovedovalci dobili šum drugih razredov. Pri tej namestitvi naj bi model dajal nepričakovano visoko natančnost. Pri pretiranem prilagajanju model morda ne bo razvrstil spremenljivke zaradi zmede, ki je nastala v logiki zaradi preveč pogojev. Tehnika odstranjevanja nazaj odvzame zunanjo funkcijo, da se izogne situaciji prekomerne namestitve.

2. Slabosti

Pomanjkljivosti odprave nazaj so naslednje:

- Pri metodi za odpravo nazaj ne moremo ugotoviti, kateri napovedovalec je odgovoren za zavrnitev drugega napovedovalca zaradi njegove nepomembnosti. Na primer, če ima napovedovalec X nekaj pomena, ki je bil dovolj dober za prebivanje v modelu po dodajanju napovedovalca Y. A pomen X zastara, ko v model pride drugi napovedovalec Z. Torej algoritem za odpravo nazaj ne kaže nobene odvisnosti med dvema prediktorjema, ki se zgodita v "tehniki izbiranja naprej".

- Po zavrženju katere koli lastnosti modela iz algoritma za odstranjevanje nazaj, te funkcije ni več mogoče izbrati. Skratka, odprava nazaj nima prilagodljivega pristopa za dodajanje ali odstranjevanje funkcij / napovedovalcev.

- Norme za izbiro vrednosti pomembnosti (0, 06) v modelu so neprožne. Odprava za nazaj nima prilagodljivega postopka, da ne samo izbere, ampak tudi spremeni nepomembno vrednost, kot je potrebno, da se doseže najboljše prileganje pod ustreznim naborom podatkov.

Zaključek

Tehnika odstranjevanja nazaj je izboljšala delovanje modela in optimizirala njegovo zapletenost. Živo se uporablja v več regresijah, kjer model obravnava obsežen nabor podatkov. To je enostaven in enostaven pristop v primerjavi z izbiro naprej in navzkrižno validacijo, pri kateri pride do preobremenitve optimizacije. Tehnika odstranjevanja nazaj začne odpravljati značilnosti večje vrednosti. Njegov osnovni cilj je narediti model manj zapleten in prepovedati prekomerno prileganje.

Priporočeni članki

To je vodnik za odpravo nazaj. Tukaj razpravljamo o tem, kako uporabiti odpravo nazaj, skupaj z zaslugami in pomanjkljivostmi. Če želite izvedeti več, si oglejte tudi naslednje članke -

- Strojno učenje hiperparametrov

- Grozd v strojnem učenju

- Java Virtual Machine

- Nenadzorovano strojno učenje