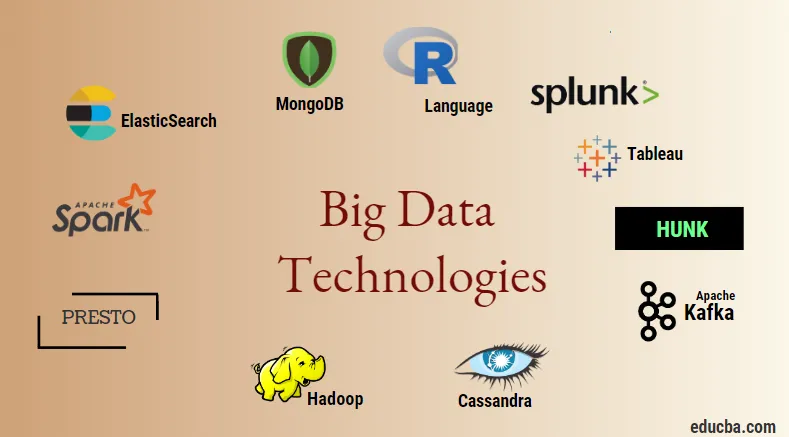

Uvod v velike podatkovne tehnologije

Velika podatkovna tehnologija in Hadoop je velika beseda, kot se morda sliši. Ker se je na področju podatkov in informacij iz vsake panoge in domene močno povečalo, je zelo pomembno, da se vzpostavi in uvede učinkovita tehnika, ki skrbi za vse potrebe in zahteve strank in velikih industrij, ki so odgovorne za pridobivanje podatkov. . Pred časom so bili podatki obdelani z običajnimi programskimi jeziki in preprostim strukturiranim poizvedbenim jezikom, vendar se zdi, da ti sistemi in orodja ne naredijo veliko v primeru velikih podatkov. Velika podatkovna tehnologija je opredeljena kot tehnologija in programski pripomoček, ki je zasnovan za analizo, obdelavo in črpanje informacij iz velikega nabora izredno zapletene strukture in velikih nizov podatkov, kar je tradicionalnim sistemom zelo težko obravnavati. Za obdelavo podatkov v realnem času in za paketne podatke se uporablja velika tehnologija podatkov. Strojno učenje je postalo zelo pomemben sestavni del vsakodnevnega življenja in vsake panoge, zato je upravljanje podatkov prek velikih podatkov zelo pomembno.

Vrste tehnologij velikih podatkov

Preden začnemo s seznamom tehnologij, si najprej oglejmo široko klasifikacijo vseh teh tehnologij. V glavnem jih je mogoče razvrstiti na 4 področja.

- Shranjevanje podatkov

- Analytics

- Izkopavanje podatkov

- Vizualizacija

Najprej pokrijemo vse tehnologije, ki spadajo pod okrilje za shranjevanje.

1. Hadoop : Ko gre za velike podatke, je Hadoop prva tehnologija, ki prihaja v poštev. Ta temelji na arhitekturi zmanjšanja zemljevidov in pomaga pri obdelavi paketnih opravil in obdelavi podatkov o šaržah. Zasnovan je bil za shranjevanje in obdelavo podatkov v razdeljenem okolju za obdelavo podatkov, skupaj z blago strojne opreme in preprostim izvedbenim modelom programiranja. Uporablja se lahko za shranjevanje in analiziranje podatkov, ki so prisotni v različnih različnih strojih, z veliko prostora za shranjevanje, hitrost in nizke stroške. To je eden glavnih sestavnih delov tehnologije velikih podatkov, ki jo je leta 2011 razvila programska fundacija Apache in je napisana na Javi.

1. Hadoop : Ko gre za velike podatke, je Hadoop prva tehnologija, ki prihaja v poštev. Ta temelji na arhitekturi zmanjšanja zemljevidov in pomaga pri obdelavi paketnih opravil in obdelavi podatkov o šaržah. Zasnovan je bil za shranjevanje in obdelavo podatkov v razdeljenem okolju za obdelavo podatkov, skupaj z blago strojne opreme in preprostim izvedbenim modelom programiranja. Uporablja se lahko za shranjevanje in analiziranje podatkov, ki so prisotni v različnih različnih strojih, z veliko prostora za shranjevanje, hitrost in nizke stroške. To je eden glavnih sestavnih delov tehnologije velikih podatkov, ki jo je leta 2011 razvila programska fundacija Apache in je napisana na Javi.

2. MongoDB : Druga zelo pomembna in temeljna komponenta velike podatkovne tehnologije v smislu shranjevanja je baza podatkov MongoDB NoSQL. Gre za bazo podatkov NoSQL, kar pomeni, da relacijske lastnosti in druge lastnosti, povezane z RDBMS, zanjo ne veljajo. Razlikuje se od tradicionalnih baz podatkov RDBMS, ki uporablja strukturiran jezik poizvedb. Uporablja sheme dokumentov, struktura shranjevanja podatkov pa je prav tako različna, zato so koristni pri shranjevanju velike količine podatkov. Gre za večplastumski program za načrtovanje in dokumentiranje, ki uporablja dokumente, podobne JSON, skupaj s shemo. To postane zelo uporaben primer uporabe operativnih shramb podatkov v večini finančnih institucij in s tem nadomešča tradicionalne glavne okvire. MongoDB skrbi za fleksibilnost in tudi široko paleto vrst podatkov pri velikih količinah in med porazdeljenimi arhitekturami.

2. MongoDB : Druga zelo pomembna in temeljna komponenta velike podatkovne tehnologije v smislu shranjevanja je baza podatkov MongoDB NoSQL. Gre za bazo podatkov NoSQL, kar pomeni, da relacijske lastnosti in druge lastnosti, povezane z RDBMS, zanjo ne veljajo. Razlikuje se od tradicionalnih baz podatkov RDBMS, ki uporablja strukturiran jezik poizvedb. Uporablja sheme dokumentov, struktura shranjevanja podatkov pa je prav tako različna, zato so koristni pri shranjevanju velike količine podatkov. Gre za večplastumski program za načrtovanje in dokumentiranje, ki uporablja dokumente, podobne JSON, skupaj s shemo. To postane zelo uporaben primer uporabe operativnih shramb podatkov v večini finančnih institucij in s tem nadomešča tradicionalne glavne okvire. MongoDB skrbi za fleksibilnost in tudi široko paleto vrst podatkov pri velikih količinah in med porazdeljenimi arhitekturami.

3. Hunk : Koristno je za dostop do podatkov prek oddaljenih grozdov Hadoop z uporabo virtualnih indeksov, poleg tega pa uporablja jezik za obdelavo iskalnih povezav Splunk, ki se lahko uporablja za analizo podatkov. Pregled se lahko uporablja za poročanje in vizualizacijo ogromnih količin podatkov iz baz podatkov in virov Hadoop in NoSQL. Razvila ga je ekipa Splunk leta 2013, ki je bila napisana na Javi.

3. Hunk : Koristno je za dostop do podatkov prek oddaljenih grozdov Hadoop z uporabo virtualnih indeksov, poleg tega pa uporablja jezik za obdelavo iskalnih povezav Splunk, ki se lahko uporablja za analizo podatkov. Pregled se lahko uporablja za poročanje in vizualizacijo ogromnih količin podatkov iz baz podatkov in virov Hadoop in NoSQL. Razvila ga je ekipa Splunk leta 2013, ki je bila napisana na Javi.

4. Cassandra : Cassandra tvori najboljšo izbiro na seznamu priljubljenih baz podatkov NoSQL, ki je brezplačna in odprtokodna baza podatkov, ki se distribuira in ima široko stolpčno shranjevanje ter lahko učinkovito obdeluje podatke na velikih grozdnih skupinah, tj. Uporablja se za zagotavljajo visoko razpoložljivost, skupaj z eno samo napako. Med seznam glavnih značilnosti so tiste, kot so porazdeljena narava, razširljivost, mehanizem za odpoved napak, podpora MapReduce, nastavljiva skladnost, lastnost jezika poizvedb, podpira večkratno kopiranje podatkovnih centrov in morebitno doslednost.

4. Cassandra : Cassandra tvori najboljšo izbiro na seznamu priljubljenih baz podatkov NoSQL, ki je brezplačna in odprtokodna baza podatkov, ki se distribuira in ima široko stolpčno shranjevanje ter lahko učinkovito obdeluje podatke na velikih grozdnih skupinah, tj. Uporablja se za zagotavljajo visoko razpoložljivost, skupaj z eno samo napako. Med seznam glavnih značilnosti so tiste, kot so porazdeljena narava, razširljivost, mehanizem za odpoved napak, podpora MapReduce, nastavljiva skladnost, lastnost jezika poizvedb, podpira večkratno kopiranje podatkovnih centrov in morebitno doslednost.

Naslednji pogovor o različnih področjih tehnologije velikih podatkov, tj. Data Mining.

5. Presto : To je priljubljen odprtokodni sistem in SQL, ki temelji na porazdeljeni poizvedbi, ki se uporablja za izvajanje interaktivnih poizvedb proti virom podatkov vsakega obsega in velikosti od gigabajtov do petabajtov. Z njegovo pomočjo lahko poiščemo podatke v Cassandri, Pive, lastniških shrambah podatkov in relacijskih sistemih za shranjevanje baz podatkov. To je mehanizem za poizvedbe, ki temelji na javi, ki ga je razvila fundacija Apache v letu 2013. Nekaj sklopov podjetij, ki dobro uporabljajo orodje Presto, so Netflix, Airbnb, Checkr, Repro in facebook.

5. Presto : To je priljubljen odprtokodni sistem in SQL, ki temelji na porazdeljeni poizvedbi, ki se uporablja za izvajanje interaktivnih poizvedb proti virom podatkov vsakega obsega in velikosti od gigabajtov do petabajtov. Z njegovo pomočjo lahko poiščemo podatke v Cassandri, Pive, lastniških shrambah podatkov in relacijskih sistemih za shranjevanje baz podatkov. To je mehanizem za poizvedbe, ki temelji na javi, ki ga je razvila fundacija Apache v letu 2013. Nekaj sklopov podjetij, ki dobro uporabljajo orodje Presto, so Netflix, Airbnb, Checkr, Repro in facebook.

6. ElasticSearch : To iskanje je danes zelo pomembno orodje. To je bistvena sestavina sklada ELK, tj. Elastično iskanje, Logstash in Kibana. ElasticSearch je lucenski knjižnični iskalnik, ki je podoben Solr-ju in se uporablja za zagotavljanje povsem razporejenega iskalnika s celotnim besedilom, ki je zmožen več najemnikom. Vsebuje seznam dokumentov JSON brez sheme in spletni vmesnik HTTP. Napisana je v jeziku JAVA, razvilo pa jo je podjetje Elastic v podjetju 2012. Imena nekaj podjetij, ki uporabljajo elastično iskanje, so: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture itd.

6. ElasticSearch : To iskanje je danes zelo pomembno orodje. To je bistvena sestavina sklada ELK, tj. Elastično iskanje, Logstash in Kibana. ElasticSearch je lucenski knjižnični iskalnik, ki je podoben Solr-ju in se uporablja za zagotavljanje povsem razporejenega iskalnika s celotnim besedilom, ki je zmožen več najemnikom. Vsebuje seznam dokumentov JSON brez sheme in spletni vmesnik HTTP. Napisana je v jeziku JAVA, razvilo pa jo je podjetje Elastic v podjetju 2012. Imena nekaj podjetij, ki uporabljajo elastično iskanje, so: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture itd.

Zdaj pa preberite vse tiste velike podatkovne tehnologije, ki so del analitike podatkov:

7. Apache Kafka : Znan po objavljanju, naročanju ali pub-sub, kot je v javnosti znan, je sistem neposrednih sporočil, asinhronski posrednik za sporočanje, ki se uporablja za zaužitje in izvajanje obdelave podatkov v realnem času. Določa tudi obdobje hrambe, podatki pa se lahko kanalizirajo z mehanizmom proizvajalec-potrošnik. Je ena izmed najbolj priljubljenih pretočnih platform, ki je zelo podobna podjetniškemu sporočalnemu sistemu ali čakalni vrsti za sporočanje. Kafka je do danes uvedla številne izboljšave, ena večja vrsta pa je povezava Kafke, ki Kafki zagotavlja dodatno raven lastnosti, kot so sistem sheme, Ktables, KSql itd. Razvila jo je programska skupnost Apache v letu 2011 in je napisano v Javi. Podjetja, ki uporabljajo to tehnologijo, vključujejo Twitter, Spotify, Netflix, Linkedin, Yahoo itd.

7. Apache Kafka : Znan po objavljanju, naročanju ali pub-sub, kot je v javnosti znan, je sistem neposrednih sporočil, asinhronski posrednik za sporočanje, ki se uporablja za zaužitje in izvajanje obdelave podatkov v realnem času. Določa tudi obdobje hrambe, podatki pa se lahko kanalizirajo z mehanizmom proizvajalec-potrošnik. Je ena izmed najbolj priljubljenih pretočnih platform, ki je zelo podobna podjetniškemu sporočalnemu sistemu ali čakalni vrsti za sporočanje. Kafka je do danes uvedla številne izboljšave, ena večja vrsta pa je povezava Kafke, ki Kafki zagotavlja dodatno raven lastnosti, kot so sistem sheme, Ktables, KSql itd. Razvila jo je programska skupnost Apache v letu 2011 in je napisano v Javi. Podjetja, ki uporabljajo to tehnologijo, vključujejo Twitter, Spotify, Netflix, Linkedin, Yahoo itd.

8. Splunk : Splunk se uporablja za zajem, korelacijo in indeksiranje pretočnih podatkov v realnem času iz iskalnega skladišča, od koder lahko ustvarja poročila, grafi, nadzorne plošče, opozorila in vizualizacije podatkov. Uporablja se tudi za varnost, skladnost in upravljanje aplikacij ter tudi za spletno analitiko, ustvarjanje poslovnih vpogledov in poslovne analize. Razvil jo je Splunk v Python, XML, Ajax.

8. Splunk : Splunk se uporablja za zajem, korelacijo in indeksiranje pretočnih podatkov v realnem času iz iskalnega skladišča, od koder lahko ustvarja poročila, grafi, nadzorne plošče, opozorila in vizualizacije podatkov. Uporablja se tudi za varnost, skladnost in upravljanje aplikacij ter tudi za spletno analitiko, ustvarjanje poslovnih vpogledov in poslovne analize. Razvil jo je Splunk v Python, XML, Ajax.

9. Apache Spark : Zdaj prihaja najbolj kritična in najbolj pričakovana tehnologija na področju tehnologij Big Data, tj. Apache Spark. Mogoče je med tistimi, ki so danes najbolj povprašeni in za svojo obdelavo uporablja Java, Scala ali Python. To se uporablja za obdelavo in obdelavo pretočnih podatkov v realnem času, tako da uporabite iskrivo pretakanje, ki za to uporablja operacije batchinga in oken. Spark SQL se uporablja za ustvarjanje podatkovnih okvirov, nizov podatkov na RDD-jih in s tem zagotavlja dober okus preobrazb in dejanj, ki so sestavni del Apache Spark Core. Druge komponente, kot so Spark Mllib, R in graphX, so uporabne tudi v primeru analiz in strojnega učenja in podatkov. Računalniška tehnika v spominu je tisto, kar jo razlikuje od drugih orodij in komponent ter podpira široko paleto aplikacij. Razvila ga je fundacija Apache Software predvsem v jeziku Java.

9. Apache Spark : Zdaj prihaja najbolj kritična in najbolj pričakovana tehnologija na področju tehnologij Big Data, tj. Apache Spark. Mogoče je med tistimi, ki so danes najbolj povprašeni in za svojo obdelavo uporablja Java, Scala ali Python. To se uporablja za obdelavo in obdelavo pretočnih podatkov v realnem času, tako da uporabite iskrivo pretakanje, ki za to uporablja operacije batchinga in oken. Spark SQL se uporablja za ustvarjanje podatkovnih okvirov, nizov podatkov na RDD-jih in s tem zagotavlja dober okus preobrazb in dejanj, ki so sestavni del Apache Spark Core. Druge komponente, kot so Spark Mllib, R in graphX, so uporabne tudi v primeru analiz in strojnega učenja in podatkov. Računalniška tehnika v spominu je tisto, kar jo razlikuje od drugih orodij in komponent ter podpira široko paleto aplikacij. Razvila ga je fundacija Apache Software predvsem v jeziku Java.

10. Jezik R : R je programski jezik in brezplačno programsko okolje, ki se uporablja za statistično računalništvo in tudi za grafiko v enem najpomembnejših jezikov v R. To je eden najbolj priljubljenih jezikov med znanstveniki, podatkovnimi rudarji in podatkovni praktiki za razvoj statistične programske opreme in večinoma za analizo podatkov.

10. Jezik R : R je programski jezik in brezplačno programsko okolje, ki se uporablja za statistično računalništvo in tudi za grafiko v enem najpomembnejših jezikov v R. To je eden najbolj priljubljenih jezikov med znanstveniki, podatkovnimi rudarji in podatkovni praktiki za razvoj statistične programske opreme in večinoma za analizo podatkov.

Zdaj se pogovorimo o tehnologijah, povezanih z vizualizacijo podatkov.

11. Tableau: To je najhitreje in močno rastoče orodje za vizualizacijo podatkov, ki se uporablja na področju poslovne inteligence. Analiza podatkov je zelo hiter stroj, ki je možen s pomočjo Tableauja in vizualizacije so ustvarjene v obliki delovnih listov in nadzornih plošč. Podjetje tableau ga je razvilo v letu 2013 in je zapisano v Python, C ++, Java in C. Podjetja, ki uporabljajo Tableau, so: QlikQ, Oracle Hyperion, Cognos itd.

11. Tableau: To je najhitreje in močno rastoče orodje za vizualizacijo podatkov, ki se uporablja na področju poslovne inteligence. Analiza podatkov je zelo hiter stroj, ki je možen s pomočjo Tableauja in vizualizacije so ustvarjene v obliki delovnih listov in nadzornih plošč. Podjetje tableau ga je razvilo v letu 2013 in je zapisano v Python, C ++, Java in C. Podjetja, ki uporabljajo Tableau, so: QlikQ, Oracle Hyperion, Cognos itd.

12. Plotly : Plotly se v glavnem uporablja za hitrejše in učinkovitejše grafe in pridružene komponente. Ima bogatejši nabor knjižnic in API-jev, kot so MATLAB, Python, R, Arduino, Julia, itd. To je mogoče interaktivno uporabljati v prenosnikih Jupyter in Pycharm in jih lahko uporabljamo za slog interaktivnih grafov. Prvič je bil razvit leta 2012 in napisan v JavaScript. Nekaj podjetij, ki uporabljajo Plotly, so paladini, bitbank itd.

12. Plotly : Plotly se v glavnem uporablja za hitrejše in učinkovitejše grafe in pridružene komponente. Ima bogatejši nabor knjižnic in API-jev, kot so MATLAB, Python, R, Arduino, Julia, itd. To je mogoče interaktivno uporabljati v prenosnikih Jupyter in Pycharm in jih lahko uporabljamo za slog interaktivnih grafov. Prvič je bil razvit leta 2012 in napisan v JavaScript. Nekaj podjetij, ki uporabljajo Plotly, so paladini, bitbank itd.

Zaključek

V tej objavi smo preučili vrhunske tehnologije velikih podatkov, ki so danes v široki uporabi. Upam, da vam je bilo všeč. Spremljajte nas za več takšnih objav.

Priporočeni članki

To je vodnik za Big Data Technologies. Tu smo razpravljali o predstavitvi in vrstah velikih podatkovnih tehnologij. Če želite izvedeti več, lahko preberete tudi druge naše predlagane članke -

- Kaj je orodje Splunk?

- R proti Pythonu

- Kaj je Matlab?

- Kaj je MongoDB?

- Naslednji koraki pri preizkušanju mainframe

- Vrste združitev v Spark SQL (primeri)

- Spoznajte različne vrste orodij Kafka