Uvod v Hadoop okvir

Preden se poglobimo v tehnični okvir Hadoopa, bomo začeli s preprostim primerom.

Obstaja kmetija, ki obira paradižnik in jih skladišči na enem samem skladišču, zdaj je z naraščajočim povpraševanjem po zelenjavi kmetija začela nabirati krompir, korenje - z naraščajočim povpraševanjem je kmetov primanjkovalo, zato so najeli več kmetov. Čez nekaj časa so ugotovili, da je v skladišču pomanjkanje - zato so zelenjavo razdelili na različna skladišča. Ko gre za pridobivanje podatkov, vsi delujejo vzporedno z lastnim prostorom za shranjevanje.

Kako je torej ta zgodba povezana z velikimi podatki?

Prej smo imeli omejene podatke, z omejenim procesorjem in eno shranjevalno enoto. Potem pa se je generacija podatkov povečala, kar je povzročilo veliko količino in različne sorte - strukturirane, polstrukturirane in nestrukturirane, zato je bila rešitev v uporabi porazdeljenega pomnilnika za vsak procesor, kar je omogočilo enostaven dostop do shranjevanja in dostopa do podatkov.

Zdaj lahko nadomestimo zelenjavo kot različne vrste podatkov in prostor za shranjevanje, kot razdeljena mesta za shranjevanje podatkov in različne delavce, ki so vsak obdelovalec.

Tako so veliki podatki izziv in Hadoop igra vlogo rešitve.

HADOOP

1. Rešitev za BIG DATA: saj obravnava zapletenosti velike količine, hitrosti in raznolikosti podatkov.

2. Nabor odprtokodnega projekta.

3. Zanesljivo shranjuje ogromno količino podatkov in omogoča ogromno porazdeljenih izračunov.

4. Ključni atributi Hadoopa so odvečnost in zanesljivost (absolutno ni izgube podatkov).

5. Osredotoča se predvsem na serijsko obdelavo.

6. Deluje na blagovni strojni opremi - ni vam treba kupiti posebne drage strojne opreme.

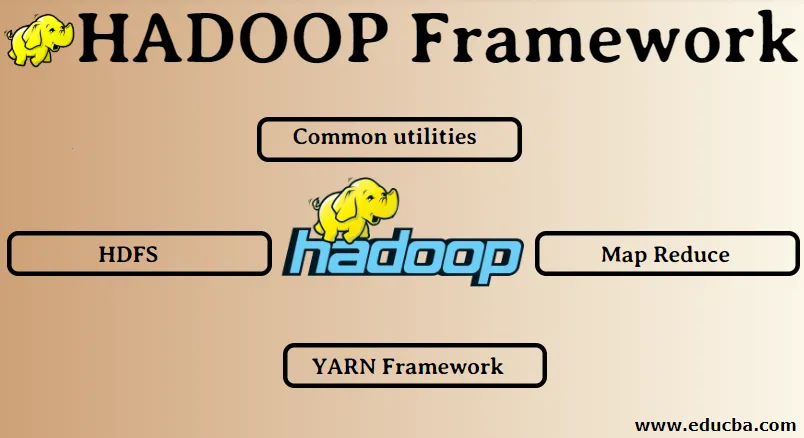

Hadoop okvir:

1. Skupni pripomočki

2. HDFS

3. Zmanjšanje zemljevida

4. Okvir preje

1. Skupne storitve:

Imenuje se tudi Hadoop navadna. To niso nič drugega kot knjižnice, datoteke, skripte in pripomočki JAVA, ki jih druge komponente Hadoop dejansko potrebujejo za izvedbo.

2. HDFS: distribucijski datotečni sistem Hadoop

Zakaj se je Hadoop odločil za vključitev distribuiranega datotečnega sistema?

Razložimo to s primerom: prebrati moramo 1TB podatkov in imamo en stroj s 4 V / I kanali, pri čemer vsak kanal ima 100MB / s, za branje celotnih podatkov pa je bilo potrebnih 45 minut. Zdaj enako količino podatkov prebere 10 strojev, vsak s 4 vhodno / izhodnimi kanali, vsak kanal pa ima 100MB / s. Uganite, koliko časa je bilo potrebno za branje podatkov? 4, 3 minute. HDFS rešuje problem shranjevanja velikih podatkov. Dve glavni komponenti HDFS sta NAME NODE in DATA NODE. Ime vozlišča je glavni, morda imamo tudi sekundarno ime vozlišča, če primarno ime vozlišča preneha delovati, bo sekundarno ime vozlišča delovalo kot varnostna kopija. Imensko vozlišče v osnovi vzdržuje in upravlja podatkovna vozlišča s shranjevanjem metapodatkov. Podatkovno vozlišče je suženj, kar je v bistvu poceni blaga strojna oprema. Lahko imamo več podatkovnih vozlišč. Podatkovno vozlišče shrani dejanske podatke. To podatkovno vozlišče podpira faktor podvajanja, če predpostavimo, da eno podatkovno vozlišče pade dol, potem lahko dostop do podatkov doseže drugo podvojeno podatkovno vozlišče, zato se izboljša dostopnost podatkov in prepreči izguba podatkov.

3. Zmanjšanje zemljevida:

Rešuje problem obdelave velikih podatkov. Razumejmo koncept zmanjšanja zemljevidov z reševanjem tega problema v resničnem svetu. Podjetje ABC želi izračunati skupno prodajo po mestu. Zdaj tukaj koncept hash tabele ne bo deloval, ker so podatki v terabajtih, zato bomo uporabili koncept Map-Reduce.

Obstajata dve fazi: a) MAP. b) Zmanjšanje

a) Zemljevid : Najprej bomo podatke razdelili na manjše koščke, imenovane preslikavci, na podlagi para ključ / vrednost. Torej tukaj bo ključno ime mesta, vrednost pa skupna prodaja. Vsak ponudnik zemljevidov bo prejel podatke za vsak mesec, ki navajajo ime mesta in ustrezno prodajo.

b) Zmanjšajte: dobili bodo te kopice podatkov in vsak reduktor bo odgovoren za mesta sever / zahod / vzhod / jug. Tako bo delo reduktorja zbralo te majhne koščke in jih pretvorilo v večje količine (tako, da jih dodate) za določeno mesto.

4.YARN Okvir: Še en pogajalec o virih.

Začetna različica Hadoopa je imela samo dve komponenti: Map Reduce in HDFS. Kasneje smo ugotovili, da Map Reduce ne more rešiti veliko velikih težav s podatki. Ideja je bila, da se odgovornosti za upravljanje virov in razporejanje delovnih mest odstranijo s starega motorja za zmanjšanje zemljevidov in mu dodelijo novo komponento. Torej, tako se je v sliko pojavil PREJ. Srednja plast med HDFS in Map Reduce je odgovorna za upravljanje virov grozda.

Za opravljanje dveh ključnih vlog: a) Načrtovanje zaposlitve. b) Upravljanje z viri

a) Razpored delovnega mesta: Ko je v obdelavo dana velika količina podatkov, jih je treba razdeliti in razdeliti na različne naloge / delovna mesta. Zdaj se JS odloči, kateremu delovnemu mestu je treba dati prednost, časovni interval med dvema zaposlitvama, odvisnost med opravili in preveri, ali se med opravljenimi opravili ne prekriva.

b) Upravljanje virov: Za obdelavo podatkov in shranjevanje podatkov potrebujemo vire, kajne? Tako upravitelj virov zagotavlja, upravlja in vzdržuje vire za shranjevanje in obdelavo podatkov.

Tako smo zdaj na jasnem konceptu Hadoopa in kako rešuje izzive, ki jih je ustvaril VELIKI PODATKI !!!

Priporočeni članki

To je vodnik za Hadoop Framework. Tu smo razpravljali tudi o najboljših 4 okvirih Hadoop-a. Če želite izvedeti več, lahko preberete tudi druge naše predlagane članke -

- Hadoop Database

- Ekosistem Hadoop

- Uporaba Hadoopa

- Hadoop Administrator Jobs

- Hadoop administrator | Spretnosti in poklicna pot