Pregled funkcij izgube v strojnem učenju

Tako kot nas vodijo učitelji, ne glede na to, ali v akademskih krogih delujemo dobro ali ne, tudi funkcije izgube opravljajo enako delo. To je metoda za oceno, kako dobro naš algoritem modelira podatke. Funkcije izgube so glavni vir vrednotenja v sodobnem strojnem učenju. Ko spremenite algoritem in izboljšate svoj model, vam bo vrednost funkcije izgube povedala, ali napredujete ali ne. Naš glavni cilj bi moral biti zmanjšanje izgube z optimizacijo. V tem članku bomo razpravljali o delovanju funkcij izgube in različnih vrstah izgub.

Kako delujejo funkcije izgube?

Beseda "izguba" navaja kazen, če ne dosežemo pričakovanega rezultata. Če je odstopanje predvidene vrednosti od pričakovane vrednosti po našem modelu veliko, potem funkcija izgube daje večje število kot izhod in če je odstopanje majhno in veliko bližje pričakovani vrednosti, odda manjše število.

Tu je primer, ko poskušamo napovedati prodajne cene hiš v metro mestih.

| Napovedano

Prodajna cena (v lakh) | Dejansko

Prodajna cena (v lakh) | Odklon (izguba) |

| Bangalor: 45 | 0 (Vse napovedi so pravilne) | |

| Pune: 35 | ||

| Chennai: 40 | ||

| Bangalor: 40 | Bangalor: 45 | 5 lakh za Bangalore, 2 lakh za Chennai |

| Pune: 35 | Pune: 35 | |

| Chennai: 38 | Chennai: 40 | |

| Bangalore: 43 | 2 lakh za Bangalore, 5 lakh za, Pune2 lakh za Chennai, | |

| Pune: 30 | ||

| Chennai: 45 |

Pomembno je opozoriti, da količina odstopanja ni pomembna, tu je pomembna stvar, ali je vrednost, ki jo napoveduje naš model, pravilna ali napačna. Funkcije izgube se razlikujejo glede na vašo težavo, na katero se nanaša strojno učenje. Funkcija stroškov je še en izraz, ki se za funkcijo izgube uporablja zamenljivo, vendar ima nekoliko drugačen pomen. Funkcija izgube je za en primer usposabljanja, medtem ko je funkcija stroškov povprečna izguba v celotnem naboru vlakov.

Vrste izgubnih funkcij v strojnem učenju

Spodaj so različne vrste izgub v strojnem učenju, ki so naslednje:

1) Regresne izgube funkcije:

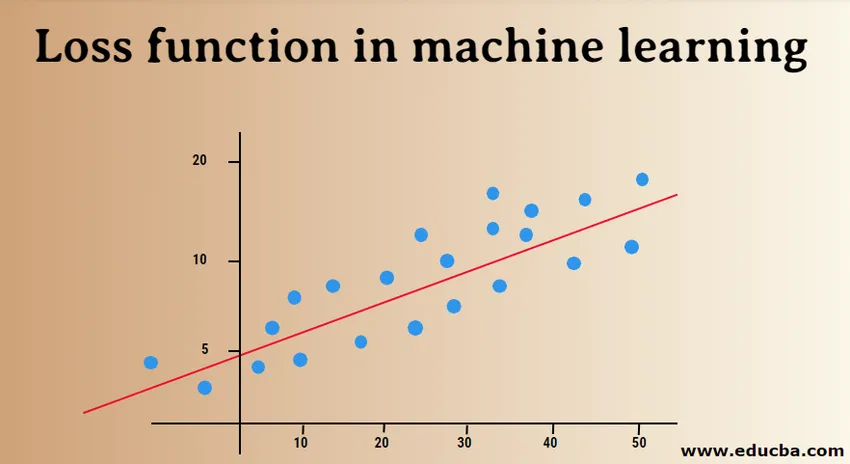

Linearna regresija je temeljni koncept te funkcije. Funkcije izgube regresije vzpostavijo linearni odnos med odvisno spremenljivko (Y) in neodvisno spremenljivko (X), zato skušamo na te spremenljivke umestiti najboljšo črto v prostoru.

Y = X0 + X1 + X2 + X3 + X4…. + Xn

X = neodvisne spremenljivke

Y = odvisna spremenljivka

- Srednja izguba napak v kvadratu:

MSE (napaka L2) meri povprečno razliko v kvadratu med dejanskimi in predvidenimi vrednostmi po modelu. Izhod je enotna številka, povezana z naborom vrednosti. Naš cilj je zmanjšati MSE, da bi izboljšali natančnost modela.

Če upoštevamo linearno enačbo, y = mx + c, lahko dobimo MSE kot:

MSE = 1 / N ∑i = 1 do n (y (i) - (mx (i) + b)) 2

Tukaj je N skupno število podatkovnih točk, 1 / N ∑i = 1 do n je srednja vrednost in y (i) dejanska vrednost, mx (i) + b pa njegova predvidena vrednost.

- Srednja logaritmična izguba napak (MSLE):

MSLE meri razmerje med dejansko in predvideno vrednostjo. Uvaja asimetrijo v krivuljo napake. MSLE skrbi le za odstotno razliko dejanskih in predvidenih vrednosti. Lahko je dobra izbira kot izguba, ko želimo napovedati prodajne cene hiš, prodajne cene pekarn in podatki so neprekinjeni.

Tukaj lahko izgubo izračunamo kot srednjo vrednost opazovanih podatkov kvadratnih razlik med log-transformiranimi dejanskimi in predvidenimi vrednostmi, ki jih lahko damo kot:

L = 1nn∑i = 1 (log (y (i) +1) −log (y (i) +1)) 2

- Srednja absolutna napaka (MAE):

MAE izračuna vsoto absolutnih razlik med dejanskimi in predvidenimi spremenljivkami. To pomeni, da meri povprečno velikost napak v naboru predvidenih vrednosti. Uporaba povprečne kvadratne napake je lažje rešiti, vendar je uporaba absolutne napake bolj odporna za odbitke. Odpuščene so tiste vrednosti, ki izjemno odstopajo od drugih opazovanih podatkovnih točk.

MAE se lahko izračuna kot:

L = 1nn∑i = 1∣∣y (i) - y (i) ∣∣

2) Funkcije izgube binarne klasifikacije:

Te funkcije izgube so narejene za merjenje zmogljivosti klasifikacijskega modela. Pri tem se podatkovnim točkam dodeli ena od nalepk, tj. 0 ali 1. Poleg tega jih je mogoče razvrstiti kot:

- Binarna navzkrižna entropija

Pri težavah z binarno klasifikacijo je privzeta funkcija izgube. Navzkrižna entropijska izguba izračuna uspešnost klasifikacijskega modela, ki daje vrednost verjetnostne vrednosti med 0 in 1. Zmanjšanje navzkrižne entropije se poveča, ko predvidena vrednost verjetnosti odstopa od dejanske oznake.

- Izguba tečajev

Izguba tečajev se lahko uporabi kot alternativa navzkrižni entropiji, ki je bila prvotno razvita za uporabo s algoritmom podpornega vektorja. Izguba tečajev najbolje deluje s težavo s klasifikacijo, ker so ciljne vrednosti v skupini (-1, 1). Omogoča dodelitev več napak, kadar je razlika med dejanskimi in predvidenimi vrednostmi razlika. Tako se dosega boljše delovanje kot navzkrižna entropija.

- Izguba šarnirja v kvadratu

Podaljšek izgube tečajev, ki preprosto izračuna kvadrat ocene izgube tečaja. Zmanjšuje funkcijo napake in omogoča številčno lažje delo. Ugotovi mejo klasifikacije, ki določa največjo mejo med podatkovnimi točkami različnih razredov. Izguba šarnirskega tečaja je popolnoma primerna za DA ali NE, kakršne koli težave pri odločanju, pri katerih odstopanje od verjetnosti ni zaskrbljujoče.

3) Funkcije izgube pri razvrstitvi v več razredov:

Razvrstitev v več razredov so napovedni modeli, v katerih so podatkovne točke dodeljene več kot dvema razredoma. Vsakemu razredu je dodeljena edinstvena vrednost od 0 do (Število_of_classes - 1). Zelo priporočljivo je pri težavah s klasifikacijo slike ali besedila, kjer ima lahko en prispevek več tem.

- Večnamenska navzkrižna entropija

V tem primeru so ciljne vrednosti v množici od 0 do n, to je (0, 1, 2, 3 … n). Izračuna rezultat, ki upošteva povprečno razliko med dejanskimi in predvidenimi vrednostmi verjetnosti, rezultat pa je zmanjšan, da dosežemo najboljšo možno natančnost. Medvrstna navzkrižna entropija je privzeta funkcija izgube pri težavah s klasifikacijo besedila.

- Redka večvrstna navzkrižna entropija

En vroč postopek kodiranja otežuje večvrstno navzkrižno entropijo težko obvladovanje velikega števila podatkovnih točk. Redka navzkrižna entropija reši to težavo z izvedbo izračuna napake, ne da bi uporabili en vroče kodiranje.

- Kullback Leibler Divergenčni izguba

KL izguba odstopanja izračuna razhajanje med verjetnostno porazdelitvijo in osnovno porazdelitvijo ter ugotovi, koliko informacij je izgubljenih v smislu bitov. Izhod je negativna vrednost, ki določa, kako blizu sta dve verjetnostni porazdelitvi. Za opis razhajanja KL glede na verjetnostni pogled uporabimo razmerje verjetnosti.

V tem članku smo na začetku razumeli, kako delujejo funkcije izgube, nato pa smo nadaljevali z raziskovanjem obsežnega seznama funkcij izgube z uporabljenimi primeri primerov. Vendar pa je razumevanje tega praktično bolj koristno, zato poskusite prebrati več in ga izvajati. Temeljito bo razjasnil vaše dvome.

Priporočeni članki

To je vodnik za izgubo funkcij v strojnem učenju. Tukaj razpravljamo, kako delujejo funkcije izgube in vrste funkcij izgube v strojnem učenju. Za več informacij si lahko ogledate tudi naslednje članke -

- Metode strojnega učenja

- Uvod v strojno učenje

- Tehnologije velikih podatkov

- Programska oprema Big Data Analytics

- Naučite se katogorij hiperparametra

- Življenjski cikel strojnega učenja | Top 8 odrov