Kaj je tehnologija velikih podatkov?

Kot vemo, se podatki stalno razvijajo. Rast podatkov je izzvala človeški um, da to pridobiva, analizira in se ukvarja s tem. To je zato, ker tradicionalni načini ravnanja s podatki ne podpirajo teh velikih podatkov. Velike podatke opisujejo običajno trije koncepti: glasnost, raznolikost in hitrost.

Podatki so zdaj postali najpomembnejša prednost vsakega podjetja. Analiza teh velikih podatkov pomaga podjetju, da analizira vedenje svojih strank in napoveduje ustrezne stvari, povezane s temi odločitvami, ki temeljijo na podatkih, da organizacija, sprejema bolj samozavestne poteze in gradi močnejše strategije.

Če poznamo tempo, s katerim se podatki v današnji dobi povečujejo, bodo veliki podatki v bližnji prihodnosti velikansko področje, na katerem bodo delali. Vsi študenti, osvežilci, strokovnjaki bodo potrebni, da se bodo sproti seznanjali z novimi tehnologijami velikih podatkov. Posodobitev sebe bo prinesla veliko in uspešno kariero na poklicni poti.

Tehnologije velikih podatkov

Tu navajam nekaj velikih podatkovnih tehnologij z natančno razlago, da vas seznanimo s prihajajočimi trendi in tehnologijo:

-

Apache Spark:

To je hiter stroj za obdelavo velikih podatkov. To je zasnovano ob upoštevanju obdelave podatkov v realnem času. Njegova bogata knjižnica strojnega učenja je dobra za delo v prostoru AI in ML. Vzporedno in v gručastih računalnikih obdeluje podatke. Osnovni tip podatkov, ki ga uporablja Spark, je RDD (prožen razporejeni nabor podatkov).

-

NoSQL baze podatkov:

Neskladne baze podatkov omogočajo hitro shranjevanje in iskanje podatkov. Njegova sposobnost, da obravnava vse vrste podatkov, kot so strukturirani, polstrukturirani, nestrukturirani in polimorfni podatki, je edinstvena. Nobena baza SQL ni te vrste:

- Podatkovne baze dokumentov : hrani podatke v obliki dokumentov, ki lahko vsebujejo veliko različnih parov ključ in vrednost.

- Grafične shrambe : hrani podatke, ki so ponavadi shranjeni v obliki omrežja, kot so podatki družbenih medijev.

- Trgovine s ključnimi vrednostmi : To so najpreprostejše baze podatkov NoSQL. Vsak posamezen element v bazi podatkov je shranjen kot ime atributa (ali 'ključ'), skupaj z njegovo vrednostjo.

- Shrambe širokih stolpcev : Ta baza podatkov shranjuje podatke v stolpnem formatu in ne v obliki vrstic. Cassandra in HBase sta dobra primera za to.

-

Apache Kafka:

Kafka je distribuirana platforma za pretakanje dogodkov, ki vsak dan obravnava veliko dogodkov. Ker je hitro in razširljivo, je to koristno pri gradnji podatkovnih cevovodov v realnem času, ki zanesljivo pridobivajo podatke med sistemi ali aplikacijami.

-

Apache Oozie:

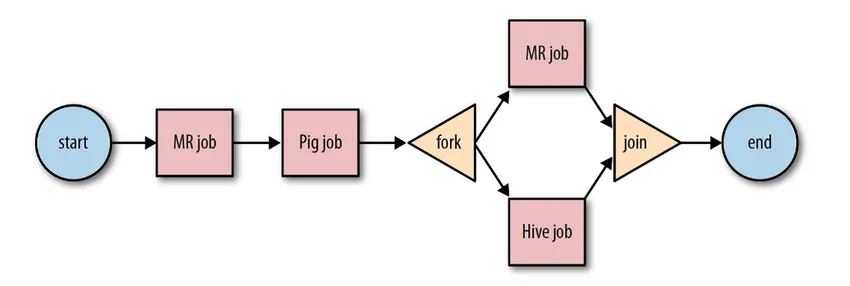

To je sistem razporejevalnika delovnih tokov za upravljanje delovnih mest Hadoop. Ta opravila delovnega toka so načrtovana v obliki usmerjenih acikličnih grafov (DAGs) za dejanja.

Vir: Google

Njegova razširljiva in organizirana rešitev za velike podatke.

-

Apache pretok zraka:

To je platforma, ki načrtuje in spremlja potek dela. Pametno načrtovanje pomaga pri učinkoviti organizaciji končnega izvajanja projekta. Zračni tok ima možnost ponovnega zagona primerka DAG, kadar pride do primera okvare. Njegov bogat uporabniški vmesnik omogoča enostavno predstavitev cevovodov, ki potekajo v različnih fazah, kot je izdelava, spremljanje napredka in odpravljanje težav, kadar je to potrebno.

-

Apache Gred:

To je poenoten model za določanje in izvajanje cevovodov za obdelavo podatkov, ki vključujejo ETL in neprekinjeno pretakanje. Okvir Apache Beam omogoča abstrakcijo med logiko vaše aplikacije in ekosistemom velikih podatkov, saj ne obstaja noben API, ki bi povezal vse okvire, kot so Hadoop, iskra itd.

-

ELK sklad:

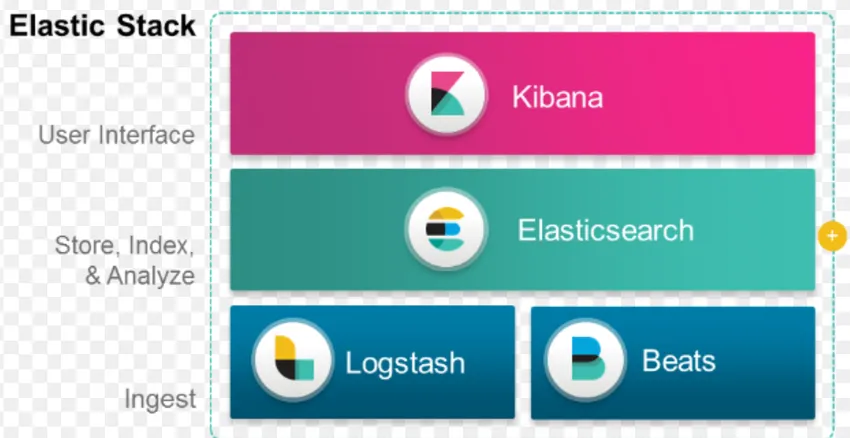

ELK je znan po Elasticsearch, Logstash in Kibana.

Elasticsearch je zbirka podatkov brez shem (ki indeksira vsako posamezno polje), ki ima zmogljive možnosti iskanja in jih je mogoče enostavno razširiti.

Logstash je orodje ETL, ki nam omogoča prenašanje, preoblikovanje in shranjevanje dogodkov v Elasticsearch.

Kibana je orodje za nadzorno ploščo za Elasticsearch, kjer lahko analizirate vse shranjene podatke. Izvedljivi izvidi iz Kibane pomagajo pri oblikovanju strategij za organizacijo. Od zajemanja sprememb do napovedovanja se je Kibana vedno izkazala za zelo koristno.

-

Docker & Kubernete:

To so nastajajoče tehnologije, ki pomagajo aplikacijam teči v posodah Linux. Docker je odprtokodna zbirka orodij, ki vam pomagajo »sestaviti, odpreti in zagnati katero koli aplikacijo kjer koli«.

Kubernetes je tudi odprtokodna platforma za zabojnike / orkestracije, ki omogoča, da veliko število zabojnikov deluje skupaj. To na koncu zmanjša operativno breme.

-

TensorFlow:

Gre za odprtokodno knjižnico strojnega učenja, ki se uporablja za načrtovanje, gradnjo in usposabljanje modelov globokega učenja. Vsi izračuni se izvajajo v TensorFlowu z grafi pretoka podatkov. Grafi vsebujejo vozlišča in robove. Vozlišča predstavljajo matematične operacije, robovi pa podatke.

TensorFlow je koristen za raziskave in proizvodnjo. Zgrajena je ob upoštevanju, da lahko deluje na več CPU-jih ali GPU-jih in celo na mobilnih operacijskih sistemih. To je mogoče uvesti v Python, C ++, R in Java.

-

Presto:

Presto je odprtokodni sistem SQL, ki ga je razvil Facebook in je sposoben obdelati petabajte podatkov. Za razliko od Hive, Presto ni odvisen od tehnologije MapReduce in zato hitreje pri pridobivanju podatkov. Njegova arhitektura in vmesnik sta dovolj enostavna za interakcijo z drugimi datotečnimi sistemi.

Zaradi nizke zamude in enostavne interaktivne poizvedbe je danes zelo priljubljena za obdelavo velikih podatkov.

-

Polibra:

Polybase deluje na vrhu SQL Serverja za dostop do podatkov, shranjenih v PDW (Parallel Data Warehouse). PDW zgrajen za obdelavo poljubne količine relacijskih podatkov in omogoča integracijo s Hadoopom.

-

Panj:

Hive je platforma, ki se uporablja za poizvedovanje podatkov in analizo podatkov v velikih zbirkah podatkov. Ponuja SQL podoben poizvedbeni jezik imenovan HiveQL, ki se notranje pretvori v MapReduce in nato obdela.

S hitro rastjo podatkov in velikim prizadevanjem organizacije za analizo velikih podatkov je tehnologija na trg prinesla toliko zrelih tehnologij, da je poznavanje le-teh v veliko korist. Danes tehnologija velikih podatkov rešuje številne poslovne potrebe in težave s povečanjem operativne učinkovitosti in napovedovanjem ustreznega vedenja. Kariera na področju velikih podatkov in z njo povezane tehnologije lahko človeku kot tudi podjetjem odpre veliko priložnosti.

Od zdaj je skrajni čas, da uporabimo tehnologije velikih podatkov.

Priporočeni članki

To je vodnik za Kaj je velika podatkovna tehnologija. Tu smo razpravljali o nekaj velikih podatkovnih tehnologijah, kot so Hive, Apache Kafka, Apache Beam, ELK Stack itd. Če želite izvedeti več, si oglejte tudi naslednji članek -

- Kaj je globinsko učenje?

- Vodnik po Minitabu?

- Kaj je tehnologija Salesforce?

- Kaj je analiza velikih podatkov?